大家好,我是R哥。

今天继续聊聊 DeepSeek R1 本地部署和可视化访问。

上一期的分享了 DeepSeek R1 本地部署实战教程来了,带可视化界面,非常详细!,使用的是 Ollama + Open WebUI 实现的。

今天再分享一种方案:Ollama + Cherry Studio,这是一种 AI 客户端形式,而非网页,使用起来更简洁,更方便快捷。

Cherry Studio 是一个支持多服务商集成的 AI 对话客户端,CherryStudio 目前支持市面上绝大多数服务商的集成,并且支持多服务商的模型统一调度。

官网地址:

它能支持的功能:

下载地址:

支持 Windows、Mac、Linux 系统,选择对应的系统下载即可。

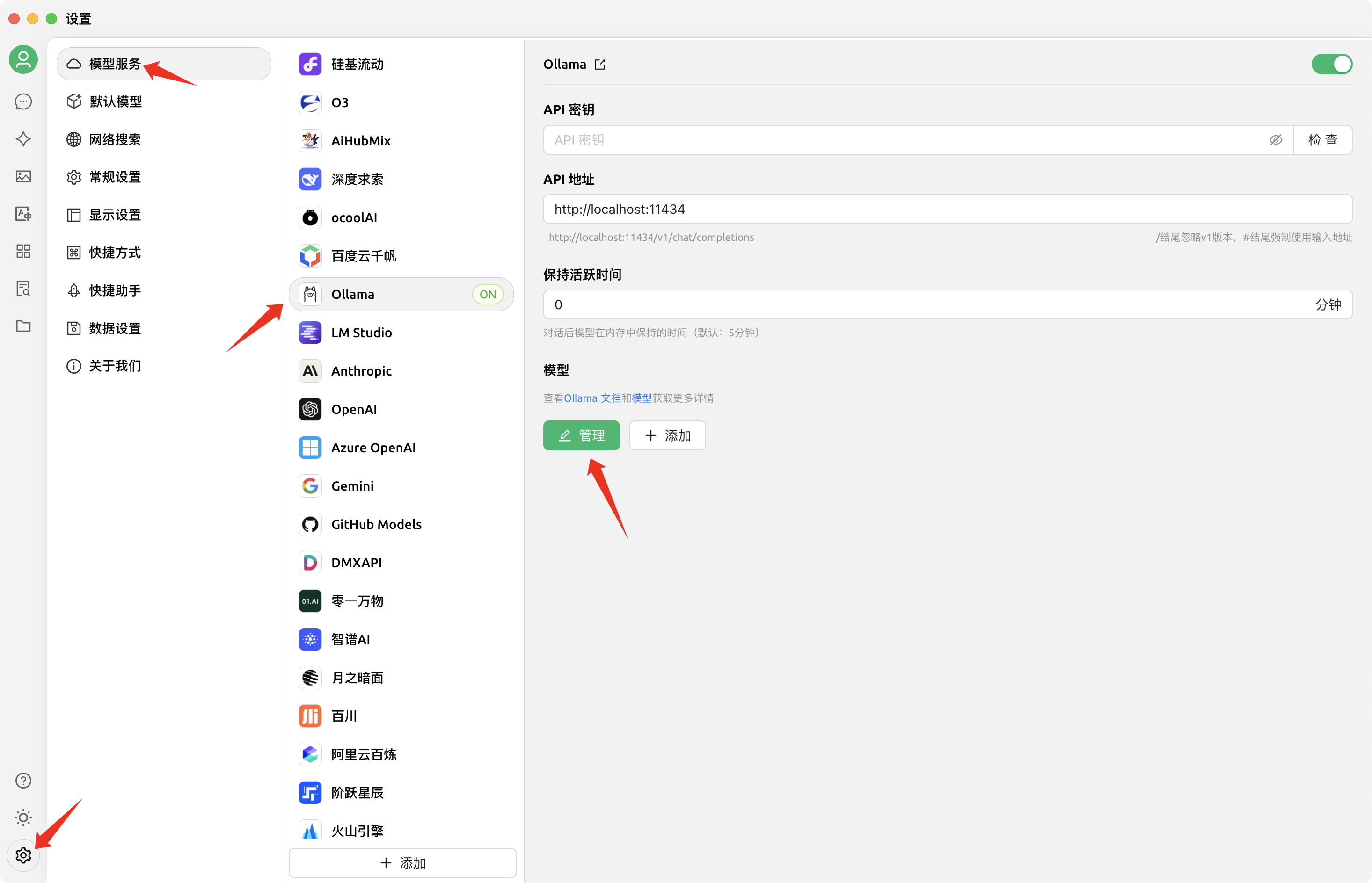

点击左下角「设置」按钮,点击「模型服务」、「Ollama」菜单,点击上角的「启用 Ollama」开关,然后再点击下面的「管理」按钮:

怎么使用 Ollama 本地部署 DeepSeek-R1 请参考上一篇文章:DeepSeek R1 本地部署实战教程来了,带可视化界面,非常详细!

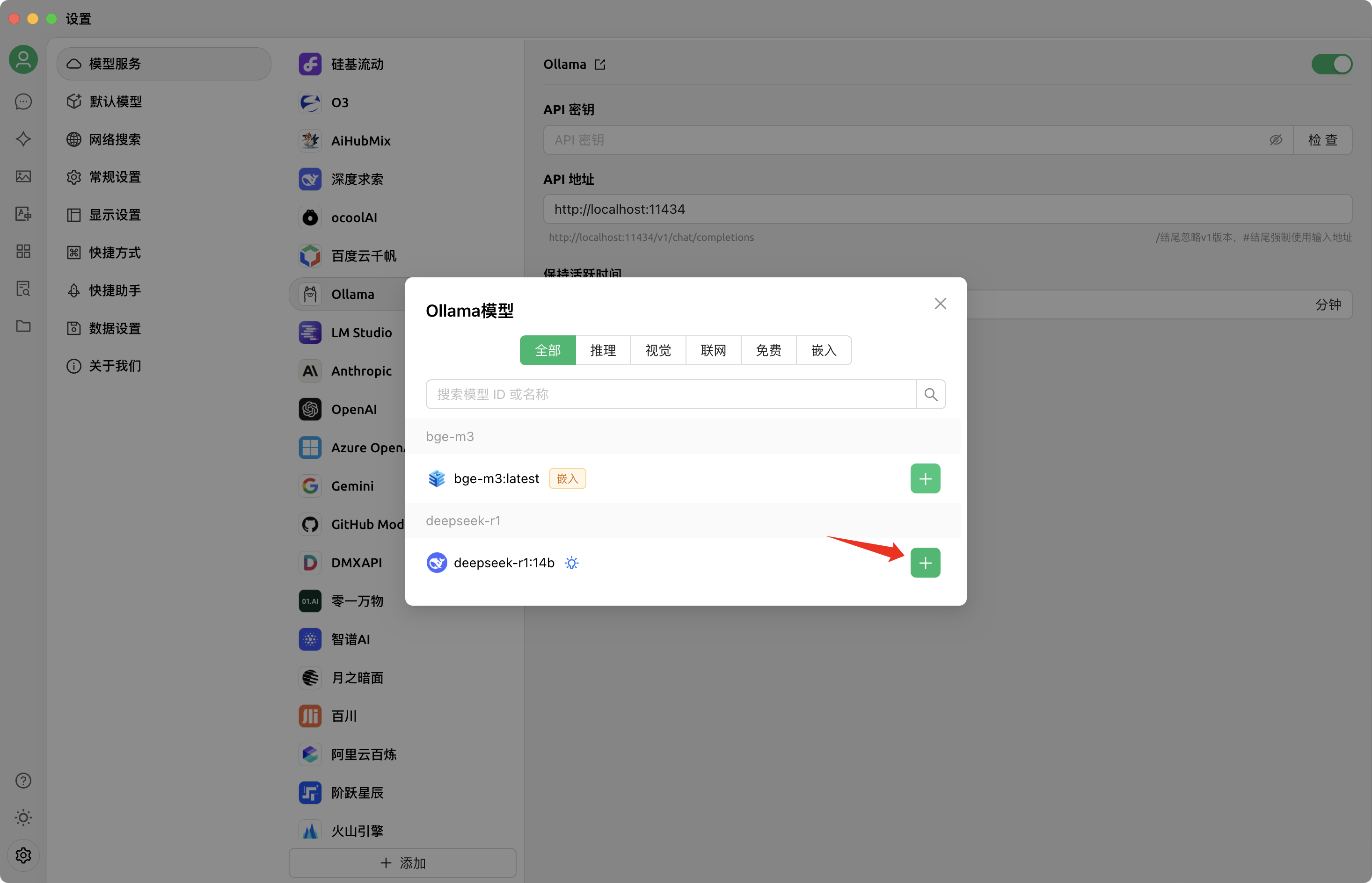

在弹出的 Ollama模型框中,点击「+」按钮,添加使用 Ollama 本地部署好的 DeepSeek-R1 模型:

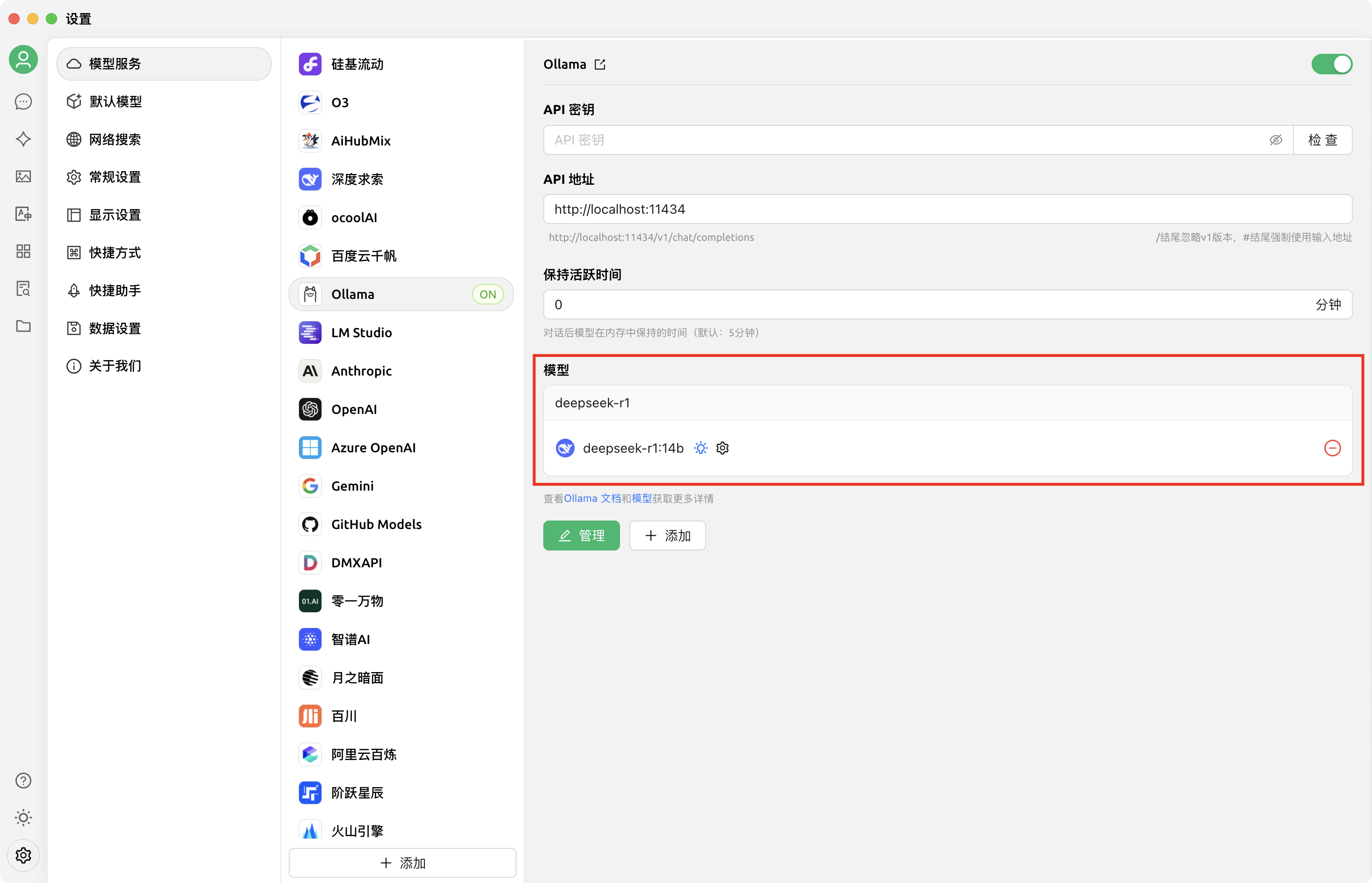

在模型中显示了 deepseek-r1,说明添加成功了。

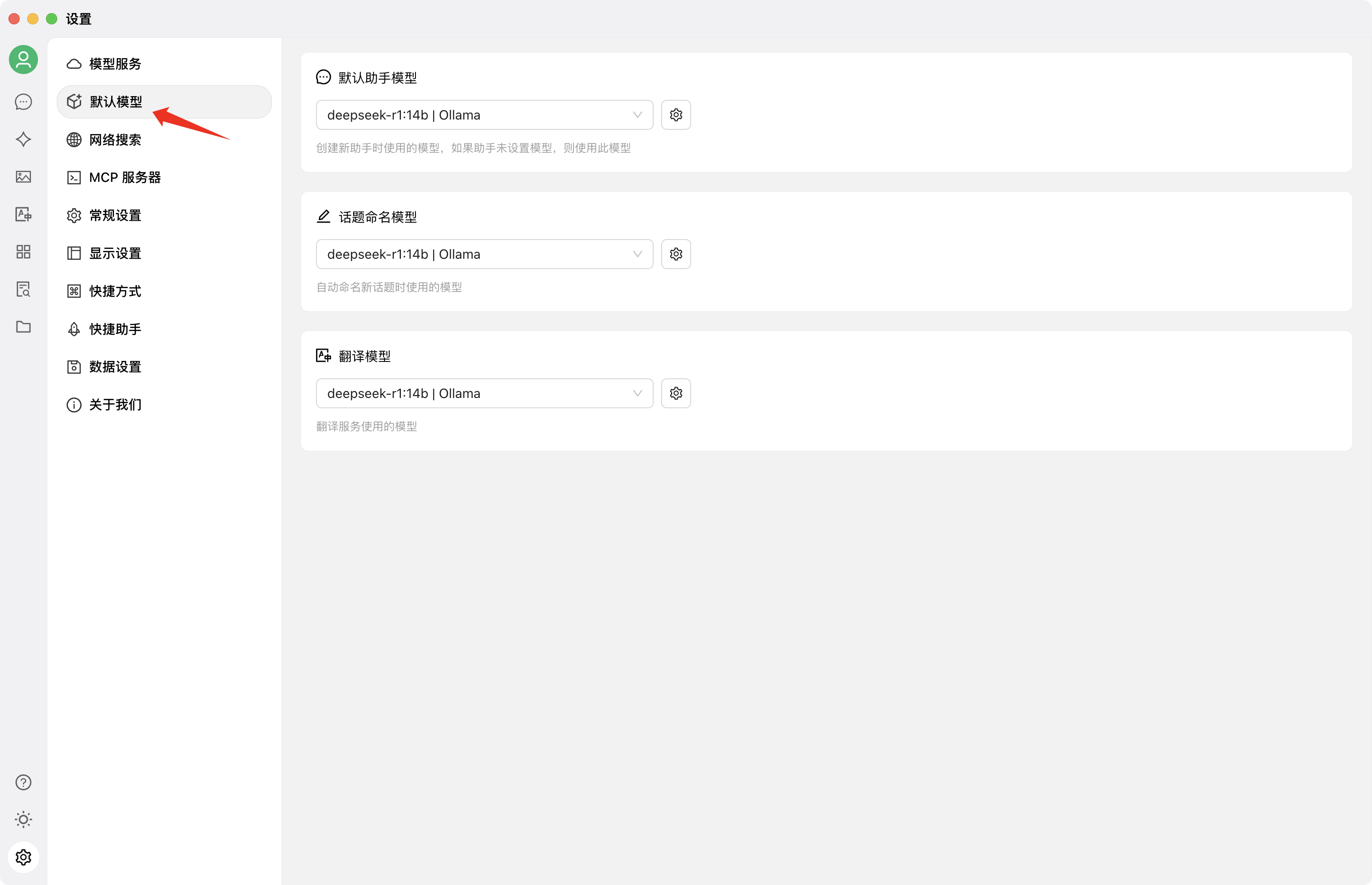

如果需要设置模型为 deepseek-r1,可以在「默认模型」菜单中进行配置:

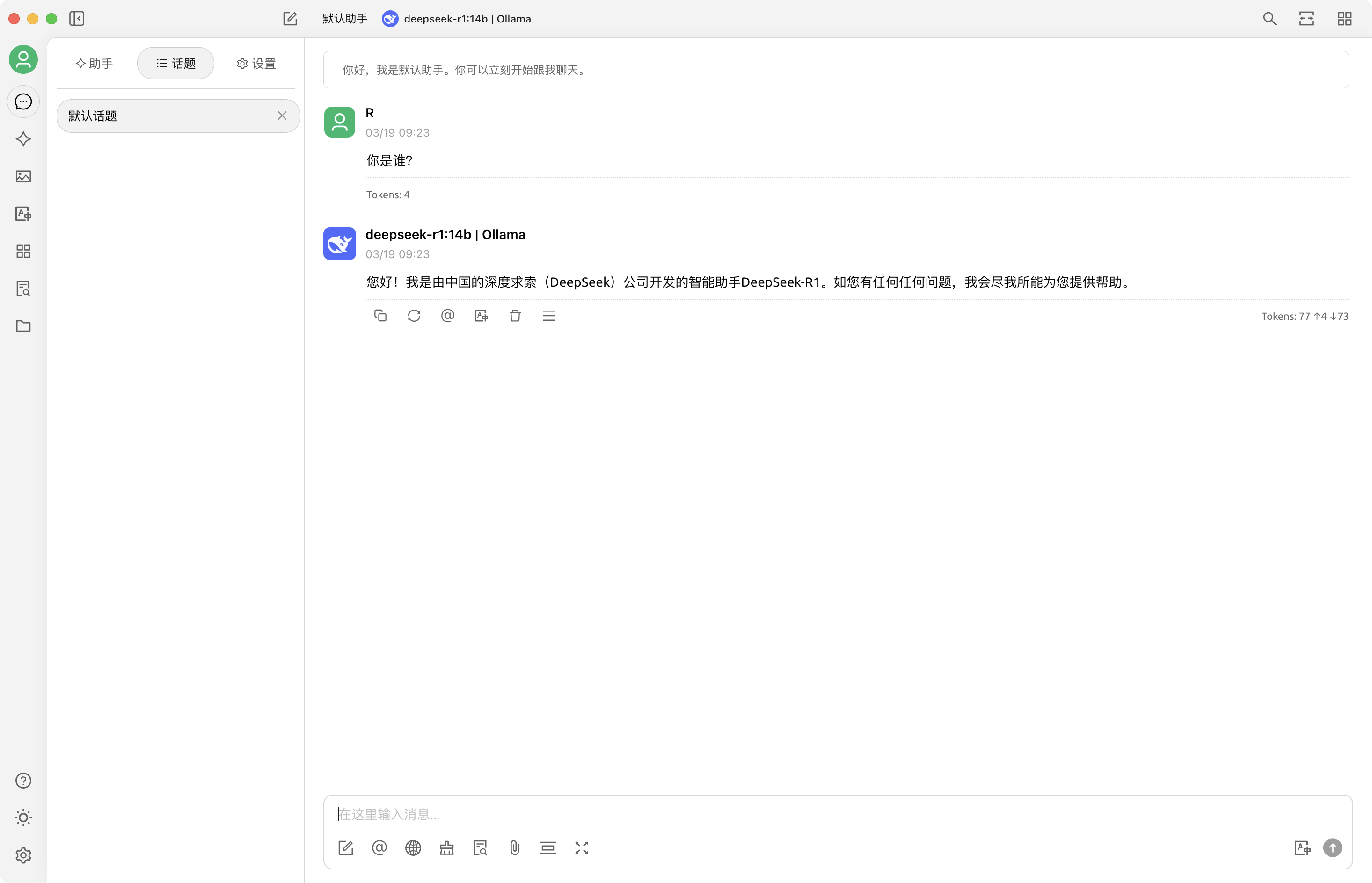

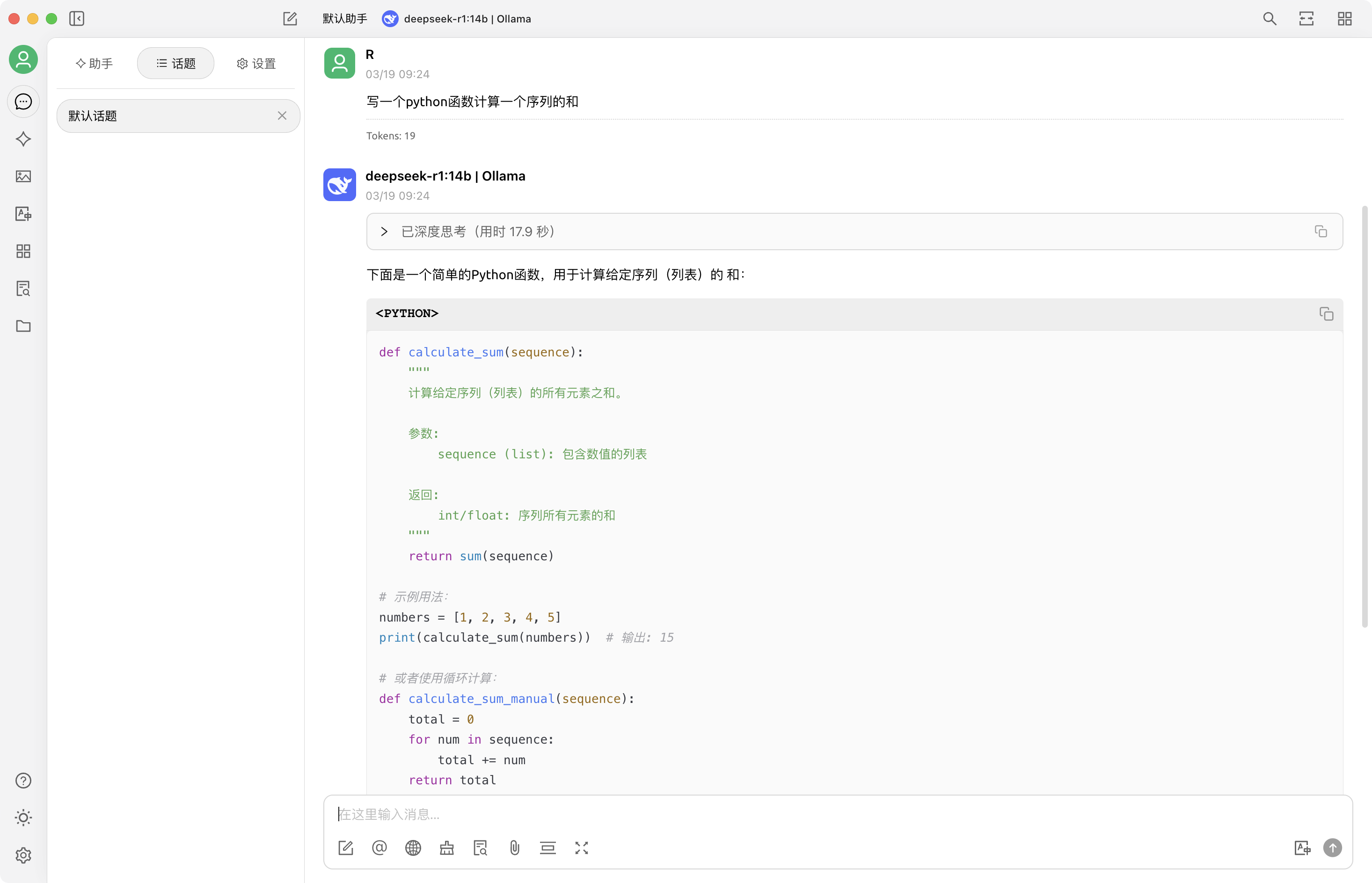

在默认助手中可以和本地部署的 deepseek-r1 进行对话了。

效果如下:

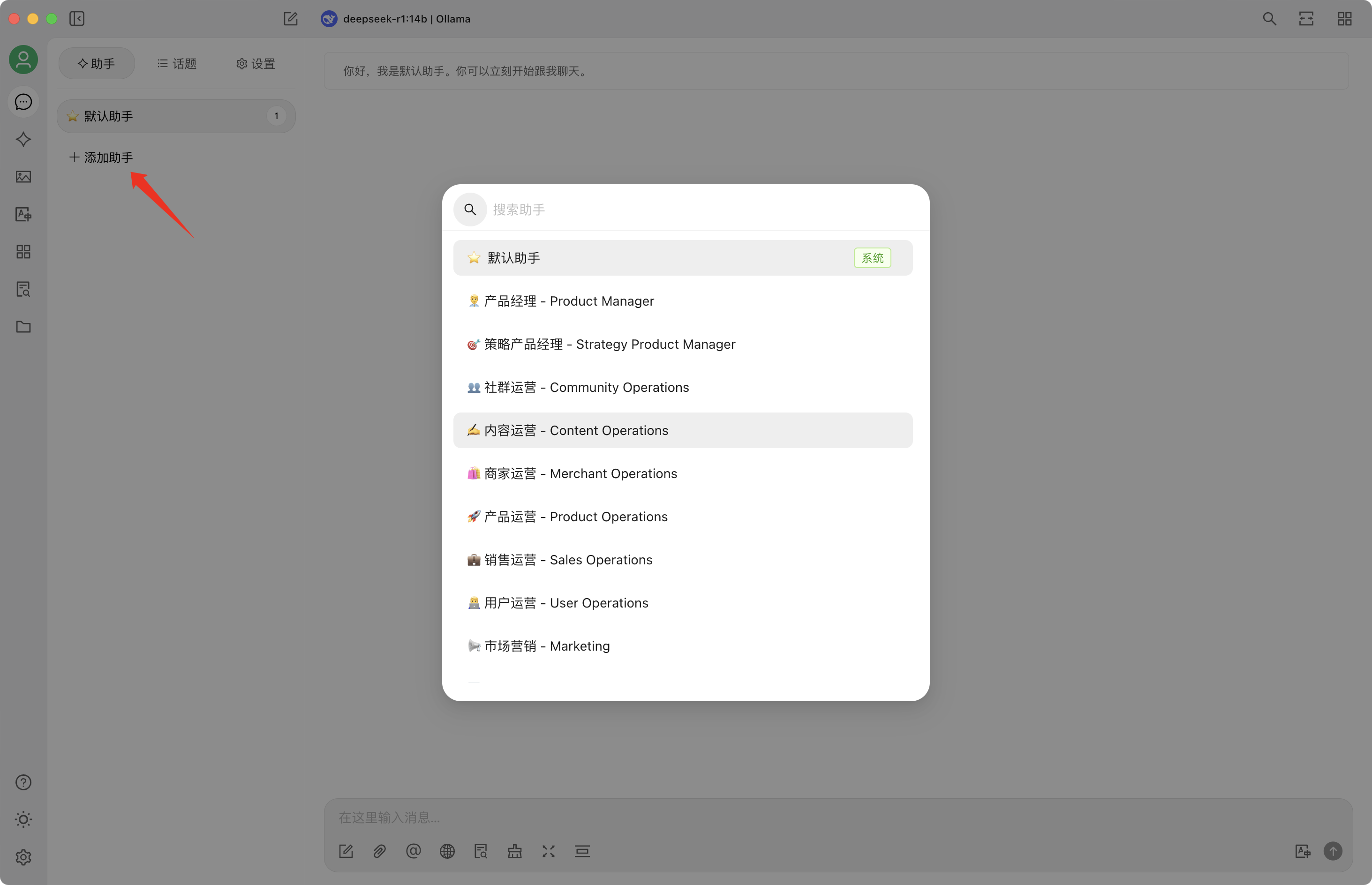

默认助手是没有定制提示词的,还可以添加各种内置的定制 AI 助手:

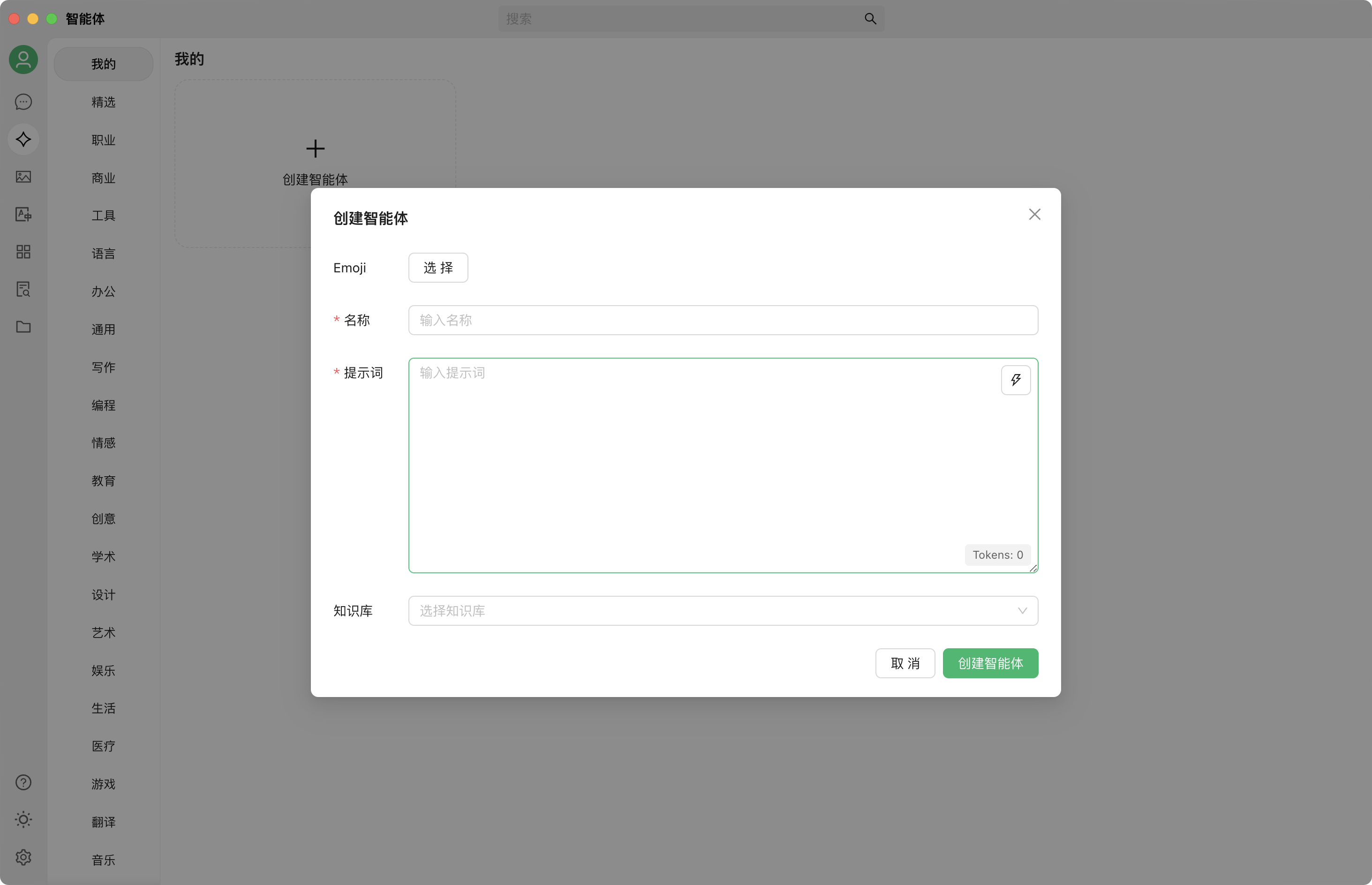

如果内置的 AI 助手不满足需求,也可以自己创建智能体:

功能很多,体验不错,使用起来也很快,没毛病。

这样一个基于 DeepSeek R1 + Ollama + Cherry Studio 的本地部署 + 可视化界面搭建就完成了,随时可用,也不用担心数据泄露问题,一般的场景够用了。

未完待续,Cherry Studio 还有好多实用性功能,比如:知识库、翻译、绘画等,公众号持续分享「DeepSeek」及 AI 实战干货,关注「AI技术宅」公众号和我一起学 AI。

最后,如果你还没用过 DeepSeek,清华大学出的《DeepSeek 从入门到精通》推荐你好好看看吧,质量非常高,从原理到应用实践,写得非常好。

版权声明: 本文系公众号 "AI技术宅" 原创,转载、引用本文内容请注明出处,抄袭、洗稿一律投诉侵权,后果自负,并保留追究其法律责任的权利。

更多文章推荐:

觉得不错,别忘了随手点赞+转发哦!

登录查看全部

登录查看全部

参与评论

手机查看

返回顶部